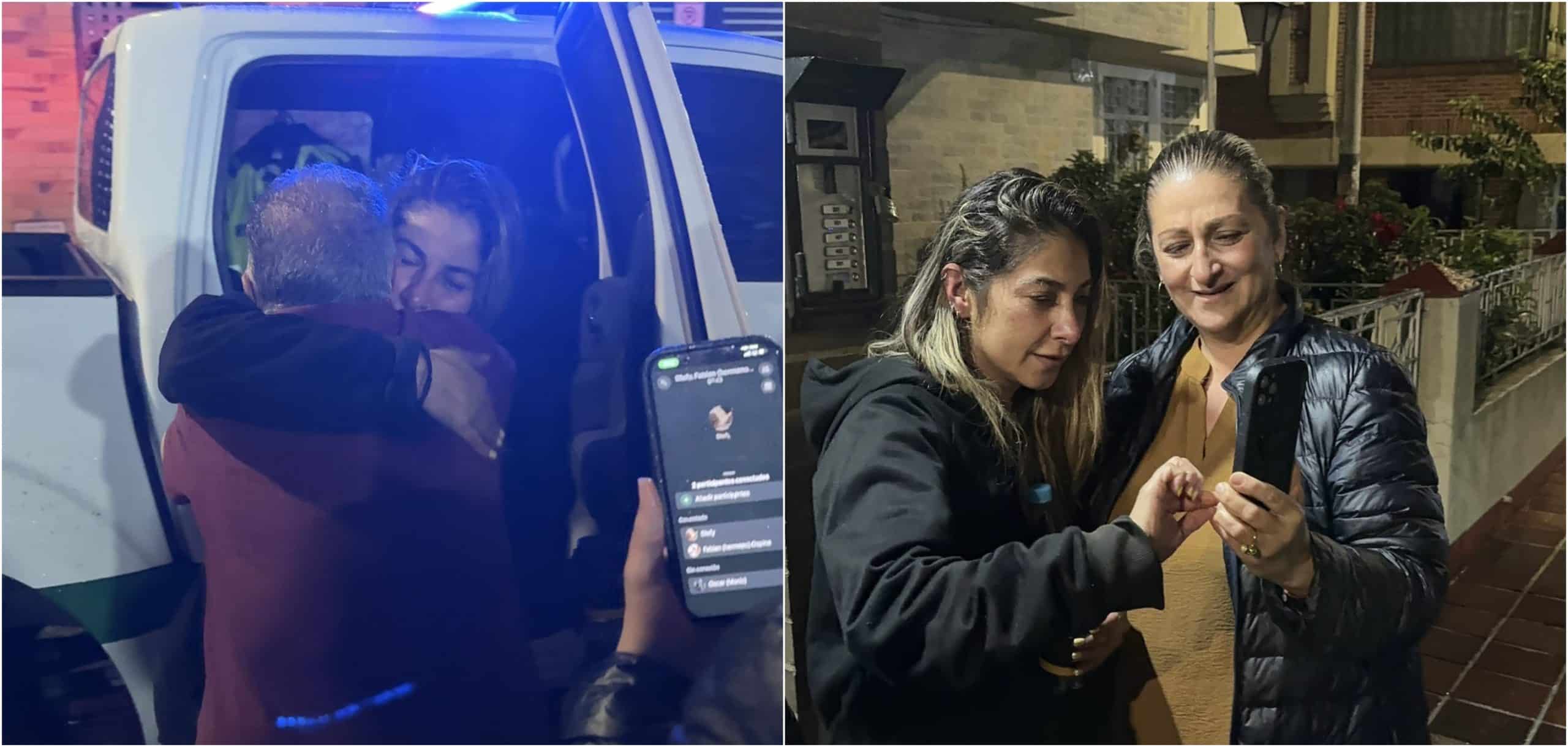

Existe preocupación por el aumento de estafas a través de dispositivos móviles. Ahora los ciberdelincuentes estarían clonando la voz de personas a través de inteligencia artificial. Especialistas entregan algunas recomendaciones para no caer en manos de personas malintencionadas.

Solo tres segundos necesitan los ciberdelincuentes para clonar una voz con inteligencia artificial. Ese tiempo es suficiente para capturar las características acústicas básicas (timbre, entonación y ritmo), para posteriormente usarla en estafas telefónicas, suplantaciones de identidad y campañas de desinformación.

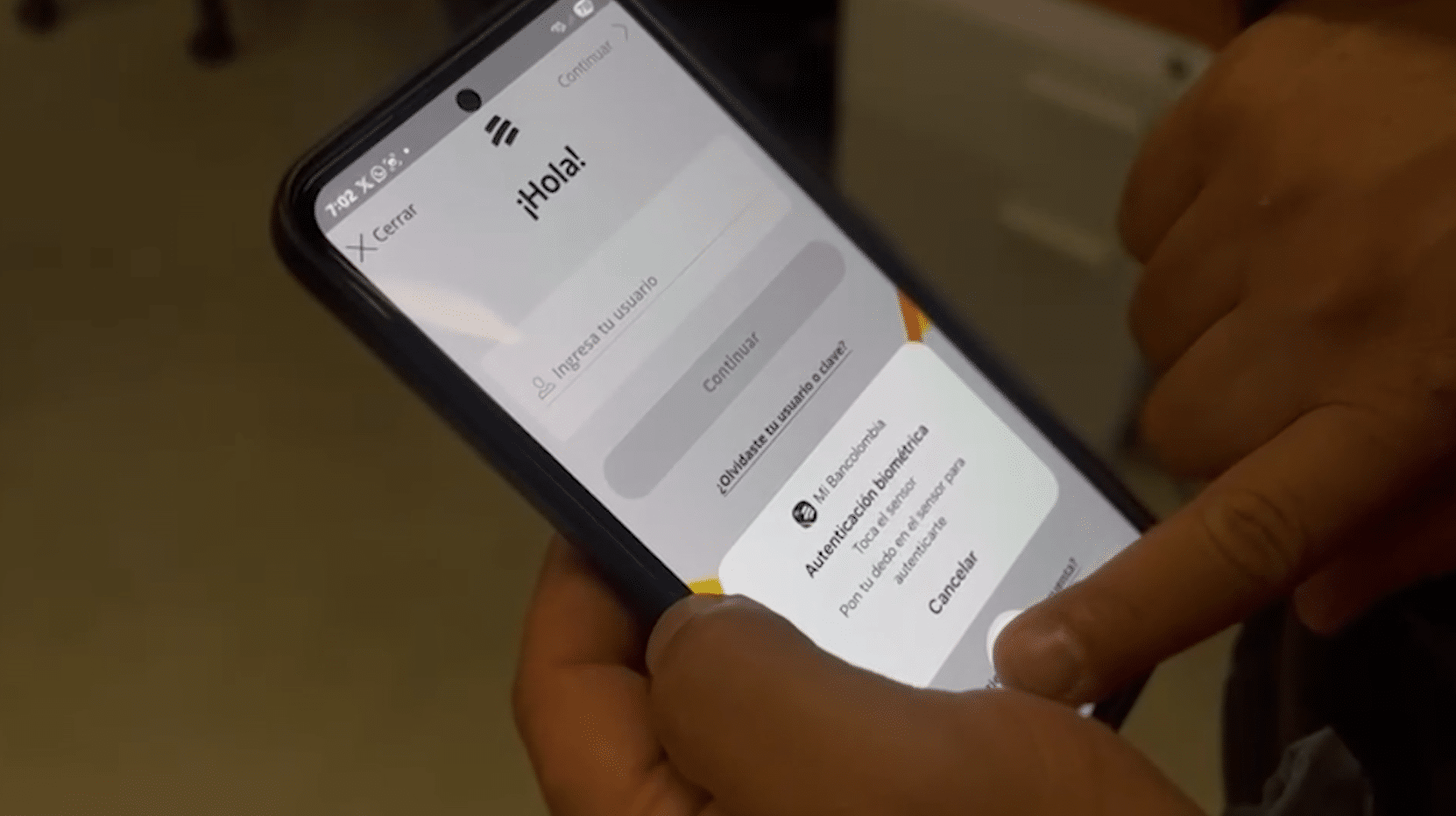

Entre los métodos más frecuentes de estafa usados por los delincuentes está simular llamadas de entidades bancarias o de familiares. Algunas de las principales alertas de cuidado son con indicativos de otros países como Bélgica o Países Bajos.

Y es que en Colombia durante 2024, según el Ministerio de Defensa y la Policía nacional, se recibieron por lo menos 67 mil denuncias por delitos informáticos.

Además, los intentos de fraude digital crecieron un 13,5 % y cerca del 30 % de los intentos se realizan a través de llamadas telefónicas.

La recomendación principal es no contestar llamada de desconocidos y por ningún caso entregar información personal vía telefónica.

Colombia cuenta con un CAI virtual donde se brinda asesoría ciudadana en atención y gestión de incidentes informáticos, se generan alertas preventivas a través de las plataformas digitales y se ejecuta el bloqueo de páginas y perfiles asociados a conductas delictivas. La página es caivirtual.policia.gov.co.

Aumentan las estafas por clonación de voz usando la inteligencia artificial

Visite además: